Nagrody Nobla za odkrycia w obszarze sztucznej inteligencji

Propagacja wsteczna

7 października, podczas szkolenia z AI dla pracowników jednego z urzędów miast, wyjaśniałem, że algorytm wstecznej propagacji to niesamowite odkrycie naukowe. Dzień później, 8 października 2024 r., odkrycie tego algorytmu zostało uhonorowane Nagrodą Nobla.

Podczas tego samego szkolenia – a tak naprawdę podczas wszystkich szkoleń, które obejmują przedstawienie podstawowej wiedzy na temat AI – opowiadałem także o sztucznej inteligencji AlphaFold, która służy do przewidywania trójwymiarowej struktury białek. Dwa dni później, tj. 9 października, stworzenie AlphaFold również zostało uhonorowane Noblem.

Wygląda na to, że to, co prezentuję na szkoleniowych slajdach, ma szczególnie wysokie szanse na Noblowskie wyróżnienia 😉W takim razie czekam na Nobla, za stworzenie najbardziej intuicyjnego i elastycznego systemu ATS ! 😉

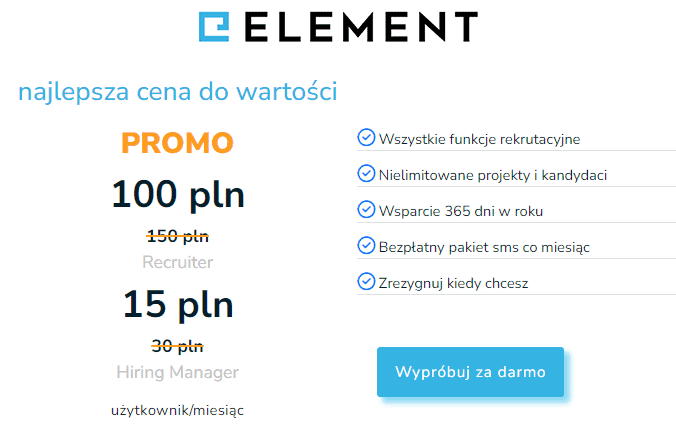

Poniżej dwa wspomniane slajdy ze szkoleń na temat AI:

Geoffrey Hinton i John Hopfield – Nagroda Nobla dla architektów rewolucji sztucznej inteligencji

Geoffrey Hinton i John Hopfield to dwaj wybitni naukowcy, których prace zrewolucjonizowały dziedzinę sztucznej inteligencji i uczenia maszynowego. Ich badania nad sztucznymi sieciami neuronowymi i algorytmem wstecznej propagacji błędu (backpropagation) stanowią fundament współczesnych technologii opartych na uczeniu głębokim. W dniu 8 października praca naukowców została uhonorowana Nagrodą Nobla.

John Hopfield i Sieci Hopfielda

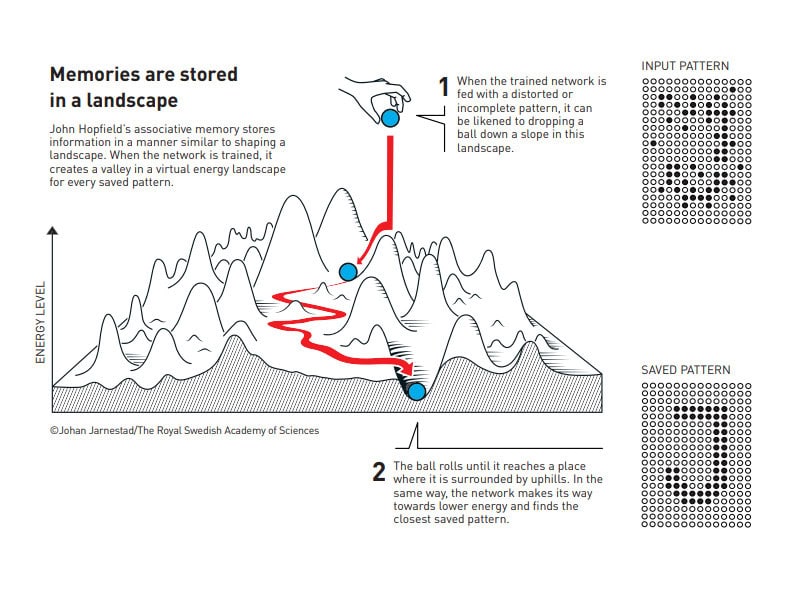

John Hopfield, profesor fizyki i biologii na Uniwersytecie Princeton, wprowadził w 1982 roku koncepcję sieci neuronowej znanej jako sieć Hopfielda. Ta sieć neuronowa działa jak pamięć, która potrafi zapisywać i odtwarzać wzorce, nawet gdy dane wejściowe są niekompletne lub zawierają zakłócenia.

Sieć Hopfielda wykorzystuje zasady fizyki statystycznej (co przemawia za przyznaniem Nobla w dziedzinie fizyki), zwłaszcza modele opisujące zachowanie magnesów, aby zminimalizować tzw. funkcję energii. Dzięki temu sieć dąży do stanu o najniższej energii, co oznacza, że odnajduje zapamiętany wzorzec najbardziej pasujący do podanych danych wejściowych. Prace Hopfielda otworzyły nowe perspektywy w zrozumieniu mechanizmów pamięci i przetwarzania informacji w mózgu oraz w sztucznych sieciach neuronowych.

Geoffrey Hinton i Algorytm Backpropagacji

Geoffrey Hinton, profesor Uniwersytetu w Toronto i badacz w Google Brain, jest uznawany za jednego z ojców chrzestnych uczenia głębokiego. W 1986 roku wspólnie z Davidem Rumelhartem i Ronaldem Williamsem, opublikował kluczową pracę wprowadzającą algorytm wstecznej propagacji błędu, znany jako backpropagation.

Backpropagation umożliwia efektywne trenowanie wielowarstwowych sieci neuronowych poprzez propagację błędu od warstwy wyjściowej do warstw wcześniejszych. Pozwala to na dostosowywanie wag połączeń neuronów w celu minimalizacji różnicy między przewidywanymi a rzeczywistymi wynikami. Mówiąc obrazowo, mechanizm ten uczy sztuczną sieć neuronową, tak jak nauczyciel uczy dziecko. Algorytm wstecznej propagacji stał się podstawą dla rozwoju zaawansowanych modeli uczenia maszynowego, zdolnych do rozpoznawania skomplikowanych wzorców w danych. To rozpoznawanie skomplikowanych wzorców jest jednym z przejawów inteligencji. Inteligencję sztucznych sieci neuronowych opisałem szerzej w artykule Czy sztuczna inteligencja jest inteligentna?

Jak Działa Backpropagacja?

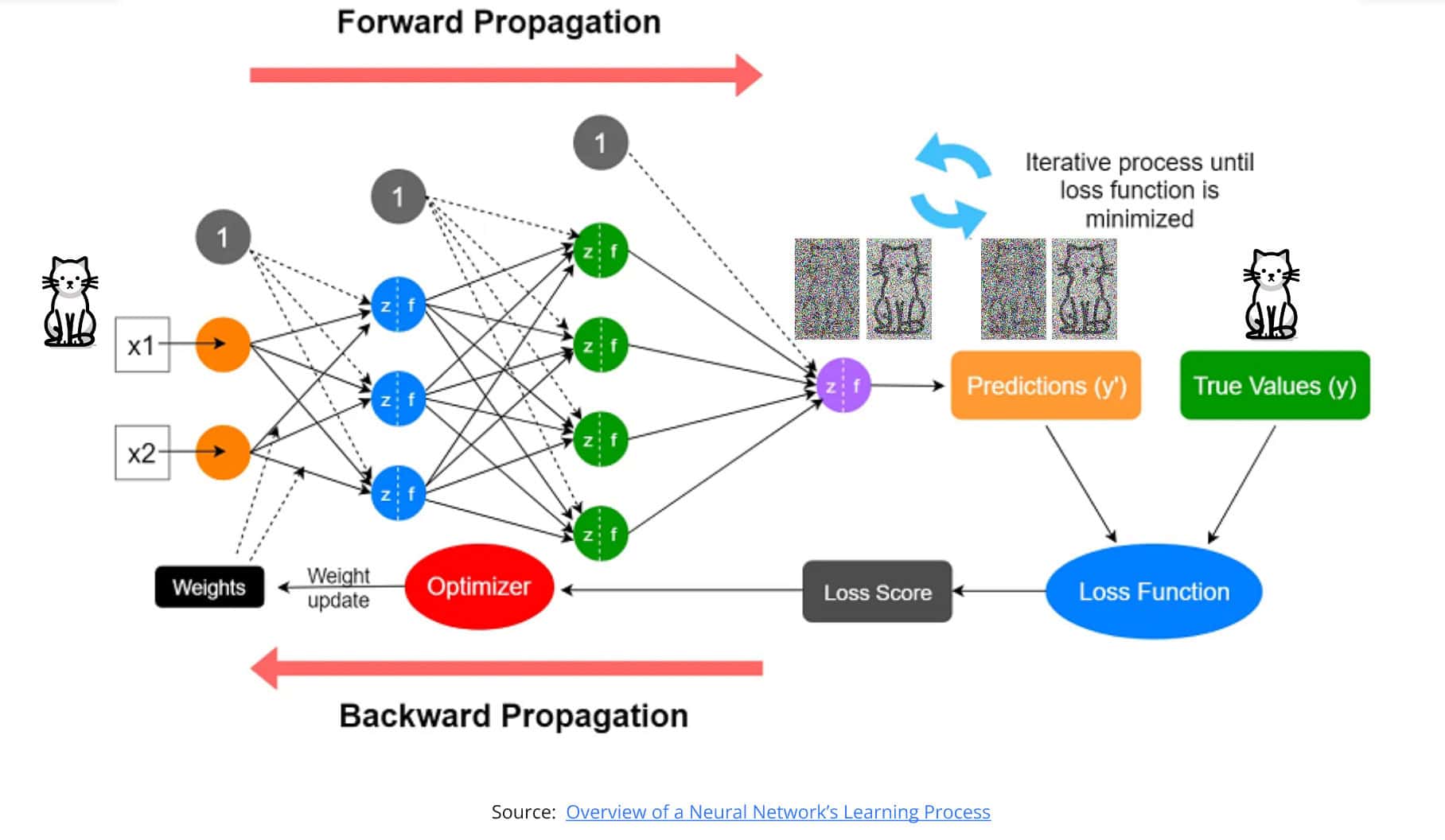

Postaram się to wyjaśnić prostym językiem. Jeszcze raz umieszczam slajd z mojej prezentacji, będzie pomocny.

Wspomniałem, że wsteczna propagacja błędu to sposób, w jaki sieci neuronowe uczą się na własnych błędach, aby poprawić swoje przyszłe odpowiedzi. Można to porównać do nauki dziecka, które popełnia błędy i uczy się, jak ich unikać w przyszłości. Oto prosty opis tego procesu:

- Przekazanie danych w przód (forward propagation):

- Wprowadzamy dane wejściowe (np. obraz kota) do pierwszej warstwy sieci neuronowej, tak zwanej warstwy wejściowej (dwa pomarańczowe neurony na slajdzie powyżej). Dla osób mniej zorientowanych – ten kot jest wprowadzany jako wartość liczbowa, wszystko, co “się dzieje” w komputerach, jest przetwarzaniem wartości liczbowych. Obrazek kotka też jest zbiorem liczb określających kolor pikseli.

- Sieć przetwarza te dane przez kolejne warstwy neuronów, dokonując obliczeń i przekazując wyniki dalej.

- Na końcu sieci neuronowej, czyli na warstwie wyjściowej (fioletowy neuron na slajdzie) , uzyskujemy odpowiedź, np. “nie rozpoznałem kota”.

- Porównanie wyniku z rzeczywistością:

- Otrzymaną odpowiedź z warstwy wyjściowej porównujemy z prawdziwą odpowiedzią (z kotkiem, którego wprowadziliśmy wcześniej na warstwie wejściowej.

- Jeśli sieć stwierdziła “nic nie rozpoznaję” albo “to pies”, wiemy, że popełniła błąd.

- Określane jest, jak duży jest błąd między przewidywaniem sieci a prawdziwym wynikiem. Jeśli sieć odpowiedziała, że nic nie rozpoznała, to błąd jest bardzo duży. Jeśli rozpoznała, że to pies, to błąd jest wciąż duży, ale mniejszy, niż gdyby nic nie rozpoznała.

- Przekazanie błędu w tył (wsteczna propagacja):

- Informacja o rozmiarze błędu przekazywana jest z powrotem przez sieć, od warstwy wyjściowej (od końca) do początkowej.

- Każdy neuron (każda kulka na slajdzie) dowiaduje się (wylicza to algorytm wstecznej propagacji, za którego odkrycie jest ten Nobel), w jakim stopniu przyczynił się do końcowego błędu. Czyli tak, jakby nauczyciel mówił dziecku “w tym miejscu popełniłeś niewielki błąd, a w tamtym trochę większy”.

- Dzięki tej informacji algorytm wylicza, które połączenia w sieci (strzałki między neuronami) wymagają korekty. Tu przypomnę, że te strzałki, czyli połączenia między neuronami, właściwie nazywane “wagami”, to wartości liczbowe, które zmieniają wartości liczbowe przechodzące od jednej warstwy do drugiej.

- Aktualizacja połączeń (wag):

- Sieć zmienia siłę (wartość liczbową) swoich połączeń (wspomnianych wag) między neuronami.

- Połączenia, które przyczyniły się do błędu, są osłabiane lub wzmacniane w odpowiedni sposób.

- W wyniku powyższego następuje poprawienie działania sieci tak, aby przy następnej próbie lepiej rozpoznała obraz.

- Powtarzanie – powyżej opisany proces powtarza się tak długo, aż wagi zostaną dostrojone w taki sposób, że sieć prawidłowo odgadnie kotka.

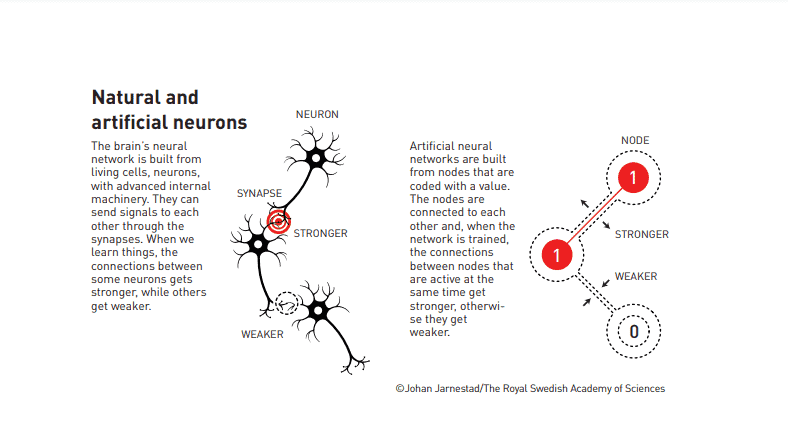

Jak widzisz, połączenia między neuronami, czyli wagi, mają kluczowe znaczenie dla funkcjonowania sztucznej sieci neuronowej. Te połączenia – jak i cała sieć – wzorowana jest na budowie mózgu, co ilustruje poniższa grafika udostępniona przez Szwedzką Akademię

Dla chętnych głębszego wejścia w szczegóły propagacji wstecznej polecam bardzo dwa poniższe materiały dwóch, moim zdaniem jednych z najlepszych twórców filmów edukacyjnych na tematy związane z AI. Materiały wymagają już nieco więcej wiedzy, niż moje uproszczone tłumaczenia, ale za to wykorzystują świetne wizualizacje i doskonałą narrację.

Reasumując, wsteczna propagacja to metoda, dzięki której sieć neuronowa uczy się na błędach:

- Sieć analizuje swoje błędne odpowiedzi, aby zrozumieć, co poszło nie tak.

- Poprzez modyfikację swoich wewnętrznych połączeń, sieć poprawia swoje przyszłe odpowiedzi.

- Proces ten jest powtarzany wielokrotnie na wielu danych, co prowadzi do coraz lepszych wyników.

Dzięki propagacji wstecznej sieci neuronowe są w stanie samodzielnie uczyć się skomplikowanych zadań, takich jak rozpoznawanie obrazów, mowy czy przewidywanie trendów, stając się coraz bardziej precyzyjne wraz z ilością przetworzonych informacji.

Podsumowanie

Algorytm propagacji wstecznej, wprowadzony przez Geoffreya Hintona i jego współpracowników, jest kamieniem milowym w dziedzinie uczenia maszynowego. Jego znaczenie w trenowaniu sieci neuronowych polega na:

- Umożliwieniu efektywnego uczenia się przez sieci neuronowe.

- Zapewnieniu mechanizmu do optymalizacji i doskonalenia modeli.

- Otwarciu drzwi do zastosowań sztucznej inteligencji w wielu dziedzinach życia.

Dzięki propagacji wsteczne sieci neuronowe, takie jak GPT wykorzystywany w ChatGPT, stały się potężnym narzędziem do rozwiązywania skomplikowanych problemów, a ich potencjał wciąż się rozwija wraz z postępem technologicznym. Nobliści, Geoffrey Hinton i John Hopfield, to wizjonerzy, których badania zdefiniowały kierunek rozwoju współczesnej sztucznej inteligencji.

Czy ten Noble słusznie przyznano w kategorii "fizyka"?

Natychmiast, po ogłoszeniu Nagrody Nobla w dziedzinie fizyki, pojawiły się wątpliwości, że przyznano nagrodę za badania, które w istocie niewiele mają wspólnego z fizyką. W dyskusji nie mogło zabraknąć głosu mojej ulubionej naukowczyni, która nie gryzie się w język i nie dba o poprawność polityczną, za co ją bardzo szanuję.

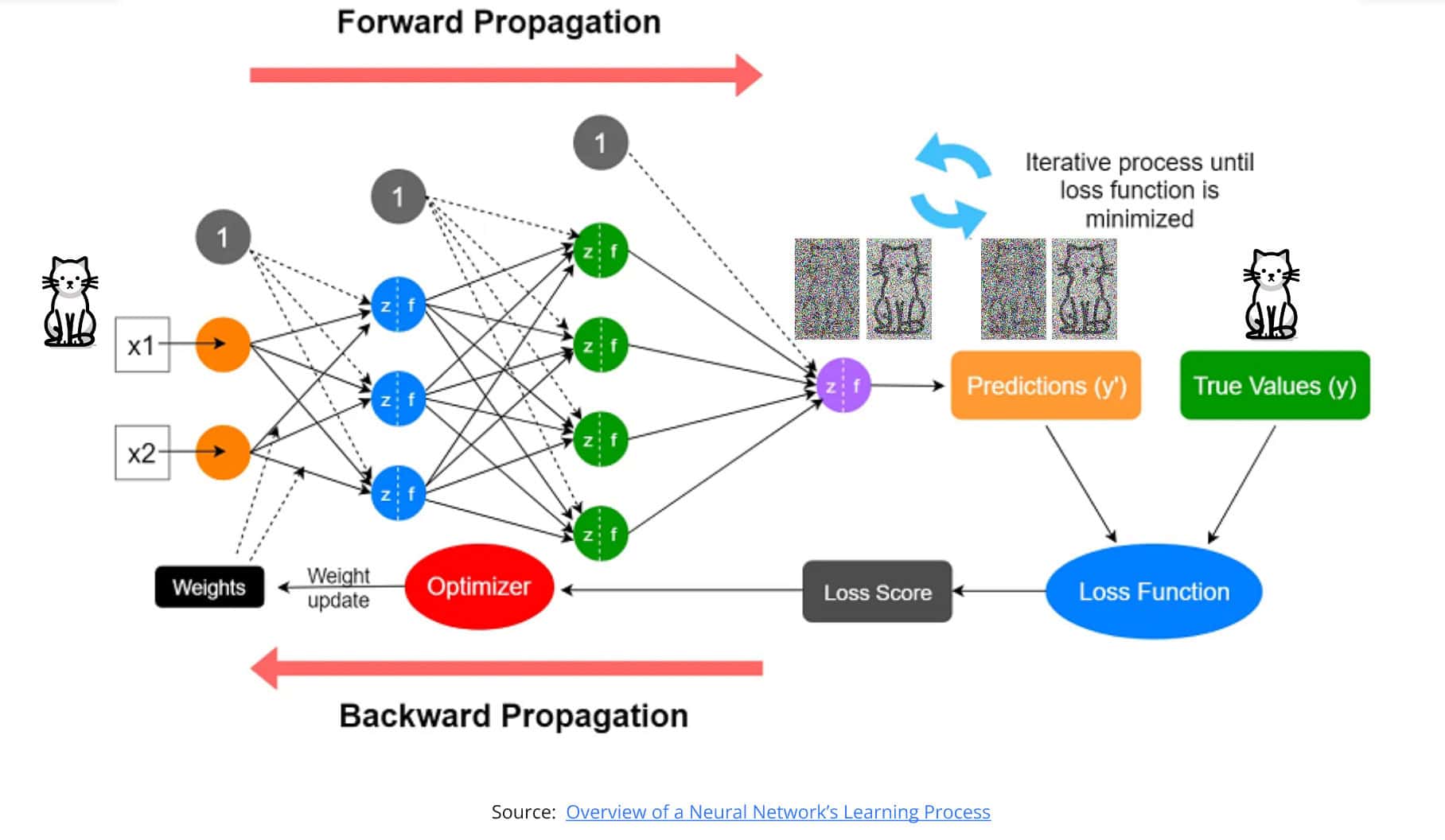

Nobel w dziedzinie chemii za przewidywanie struktury białek za pomocą AI

Szwedzka Akademia ogłosiła 9 października, że Nagrodę Nobla w dziedzinie chemii za rok 2024 otrzymali:

- David Baker – za komputerowe projektowanie białek.

- Demis Hassabis i John M. Jumper – za przewidywanie struktur białek.

Tu również sztuczna inteligencja ma zasadniczą rolę. Przełomowe prace laureatów zrewolucjonizowały sposób, w jaki naukowcy rozumieją i manipulują białkami, otwierając nowe horyzonty w medycynie, biotechnologii i biologii molekularnej. Dzięki pracy badaczy powstała sztuczna inteligencja AlphaFold, która przewiduje trójwymiarową strukturę białek. To właśnie ta trójwymiarowa struktura definiuje właściwości białek i ma kluczowe znaczenie dla badań, np. nad lekami.

David Baker, profesor na Uniwersytecie Waszyngtońskim, jest pionierem w dziedzinie projektowania białek z wykorzystaniem metod obliczeniowych. Jego laboratorium opracowało Rosetta, narzędzie programistyczne, które pozwala naukowcom projektować nowe białka o określonych funkcjach, które nie występują w naturze.

Trzy kluczowe osiągnięcia Davida:

- Tworzenie nowych białek – Baker i jego zespół zaprojektowali białka zdolne do wiązania się z wirusami, neutralizując je, co ma ogromny potencjał w terapii chorób zakaźnych.

- Enzymy na zamówienie – udało im się stworzyć enzymy katalizujące reakcje chemiczne, które wcześniej były trudne lub niemożliwe do przeprowadzenia w warunkach biologicznych.

- Współpraca Globalna – poprzez platformę Foldit, umożliwili społeczności naukowej udział w procesie odkrywania nowych struktur białkowych.

Demis Hassabis i John M. Jumper są kluczowymi postaciami w firmie DeepMind, specjalizującej się w sztucznej inteligencji. Ich zespół stworzył AlphaFold, rewolucyjny system wykorzystujący głębokie uczenie maszynowe do przewidywania trójwymiarowych struktur białek na podstawie sekwencji aminokwasów.

Główne osiągnięcia:

- Przewidywanie struktury białek było jednym z największych wyzwań w biologii molekularnej przez ponad 50 lat. AlphaFold osiągnął precyzję porównywalną z metodami eksperymentalnymi.

- Przyspieszenie badań – dzięki AlphaFold naukowcy mogą teraz szybko i dokładnie określać struktury białek, co przyspiesza badania nad chorobami i rozwojem nowych leków.

- Dostępność danych – DeepMind udostępnił przewidywane struktury dla ponad miliona białek, co stanowi ogromny zasób dla społeczności naukowej.

Znaczenie badań

Prace tych trzech naukowców i wykorzystanie w badaniach sztucznej inteligencji mają fundamentalne znaczenie dla nauki i medycyny:

- Innowacje w medycynie – projektowanie i przewidywanie struktur białek otwiera drogę do tworzenia nowych terapii, szczepionek i leków.

- Zrozumienie chorób – pozwala na głębsze zrozumienie mechanizmów chorób na poziomie molekularnym, co jest kluczowe dla opracowywania skutecznych interwencji.

- Przyspieszenie odkryć naukowych – narzędzia te eliminują konieczność czasochłonnych i kosztownych metod eksperymentalnych, przyspieszając postęp w wielu dziedzinach nauki.

Podsumowanie

Nagroda Nobla w chemii za rok 2024 uhonorowała prace, które zrewolucjonizowały nasze podejście do biologii molekularnej i biotechnologii. David Baker, Demis Hassabis i John M. Jumper stworzyli narzędzia i metody, które nie tylko rozwiązują wieloletnie naukowe zagadki, ale także mają bezpośredni wpływ na poprawę jakości życia poprzez rozwój nowych terapii i leków.

Ich osiągnięcia symbolizują moc interdyscyplinarnej współpracy między chemią, biologią i informatyką, pokazując, jak połączenie tych dziedzin może prowadzić do przełomowych odkryć o globalnym znaczeniu.

Najczęściej czytane:

- Darmowe ogłoszenia o pracę i największa lista źródeł kandydatów – największa w Polsce lista bezpłatnych i płatnych źródeł kandydatów

- Praca w HR – najnowsze oferty pracy i aktualne średnie wynagrodzenia w branży HR

- Akademia Rekrutacji – zbiór wiedzy na temat rekrutacji oraz raporty z rynku pracy.

- Gowork – jak reagować na negatywne opinie o pracodawcach – Kompleksowy poradnik dla pracodawców.

- Sztuczna inteligencja w rekrutacji i Chat GPT-3 – wszystko co musisz wiedzieć o najnowszej wersji sztucznej inteligencji i jej możliwych zastosowaniach, także w rekrutacji.

- RODO w rekrutacji – sourcing, direct search, ogłoszenia. Wszystko co musisz wiedzieć – kompleksowy poradnik RODO w rekrutacji z naciskiem na działania typu direct search / sourcing.

- Wszystko o systemach ATS – poradnik wyboru systemu rekrutacyjnego

Maciej Michalewski

Founder & CEO @ Element

Ostatnie wpisy:

Nie widzę przyszłości dla MS Office

Trzy fazy przejścia od klikania w przyciski do poleceń AI. Dlaczego Microsoft Office jest skazany na wyginięcie i co go zastąpi.

Oferty rosną o 11%, a Dorsey tnie połowę firmy. Co się dzieje?

Oferty rosną o 11%, a Dorsey tnie połowę firmy. Co się dzieje? Wprowadzenie Dane, które mnie zaskoczyły Piszę o automatyzacji od lat. Uważam ją za

Postings up 11%, Dorsey cuts 40%. What’s going on with dev jobs?

The data that surprised me I’ve been writing about work automation for years. I consider it inevitable and, in the long run, beneficial. So when

Nowość w Elemencie: integracja ze Staffly i automatyczne testy

Integracja Element ze Staffly automatyzuje wysylke testow kandydatom, pokazuje status wykonania i przyspiesza preselekcje z raportami w jednym miejscu.

AI intensyfikuje zamiast redukować pracę? Konsekwencje dla HR

Badania HBR pokazują, że AI intensyfikuje pracę zamiast ją redukować. Omówienie raportu opracowanego przez Harvard Business Review.

Raport ofert pracy – styczeń wyhamowuje spadki

Styczniowy raport ofert pracy rodzi mieszane uczucia. Trend jest wciąż spadkowy, ale spadek ten wyhamowuje. Przedstawiamy dane i komentarze.