Raport Microsoft twierdzi, że AI diagnozuje lepiej niż lekarze

AI w medycynie - od testów jednokrotnego wyboru do prawdziwego myślenia klinicznego

Gdy natrafiłem na ten raport, to od razu przypomniał mi się jeden z postów na LinkedIn, który zdarza mi się przytaczać podczas szkoleń z AI. Pewna Pani opisała, jak trafiła na SOR z ciężkim bólem brzucha tylko po to, by zostać odesłana do domu bez konkretnej diagnozie. Pani wspomniała, że w wywiadzie, które przeprowadzał z nią lekarz, stwierdziła, że ma ADHD. Lekarz rzekomo słysząc to stwierdził, że Pani nic poważnego nie dolega i odesłał ją do domu. Po kilku godzinach wróciła, z jeszcze większym bólem i dopiero wówczas wzięto sprawę na poważnie.

Co to ma wspólnego z AI?

Ano to, że jeden z komentujących skopiował opisane przez autorkę posta objawy (nie pamiętam ich, więc ich nie przytoczę). Następnie skopiowane objawy wkleił do ChatGPT i poprosił o diagnozę. Diagnoza ChatGPT okazała się trafiona.

Badanie

Microsoft opublikował niedawno badanie Sequential Diagnosis with Language Models, opracowane przez ekspertów z zespołu Microsoft AI oraz partnerów z różnych dziedzin medycyny, informatyki i analizy danych.

Naukowcy przekształcili 304 trudne przypadki kliniczne opublikowane w New England Journal of Medicine w interaktywne symulacje. AI lub lekarz dostaje na start tylko krótki opis przypadku i musi zadawać pytania albo zlecać badania, żeby ostatecznie postawić diagnozę. Każda decyzja wpływa nie tylko na trafność rozpoznania, ale też na całkowity koszt diagnostyki.

Wynik?

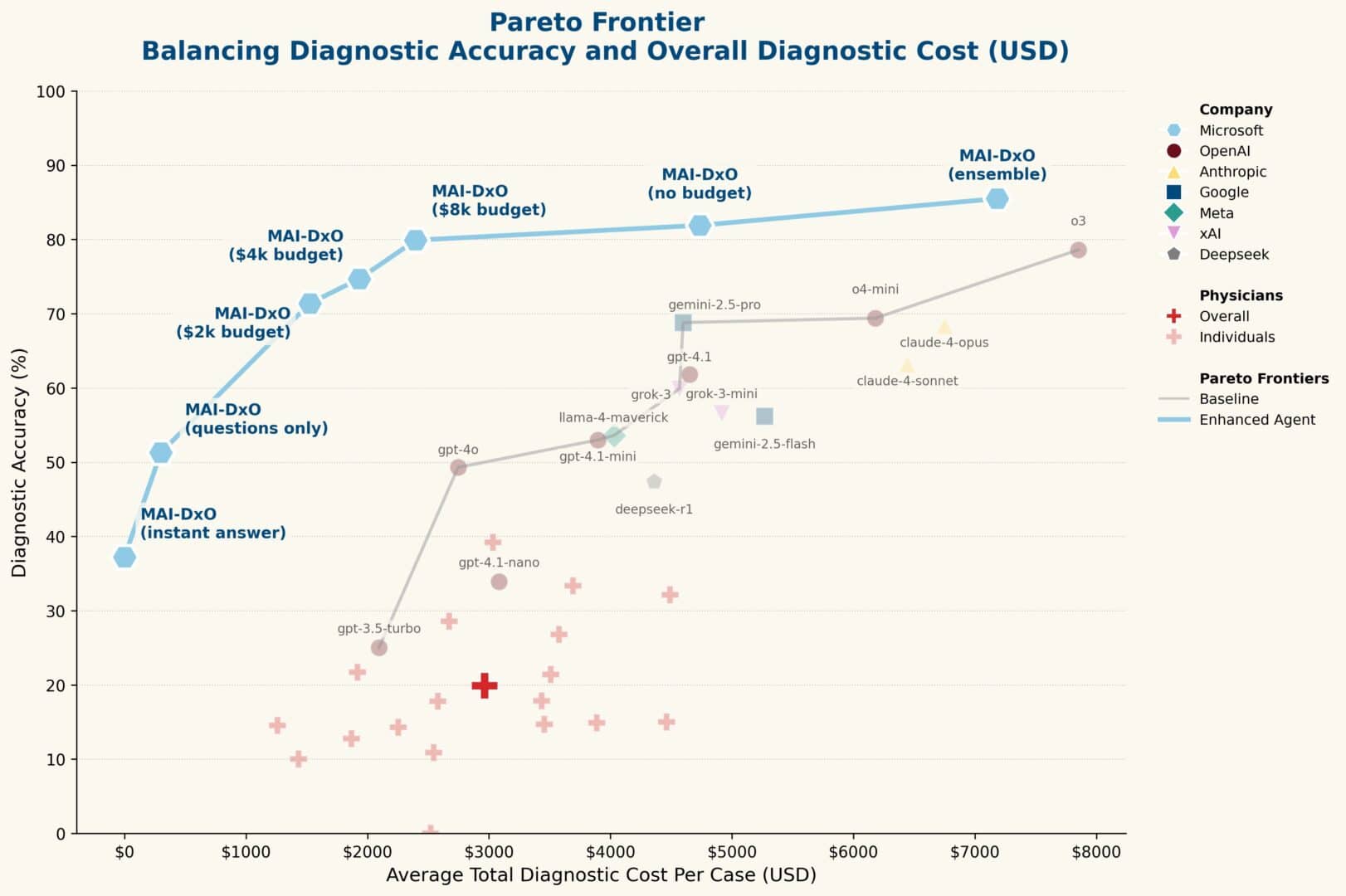

W testach udział wzięło 21 doświadczonych lekarzy z USA i UK. Ich średnia trafność wyniosła 20%, a koszt diagnostyki jednego przypadku – blisko 3000 dolarów.

Dla porównania, „surowy” model:

a. GPT-4o osiągnął 49% trafności przy niższym koszcie

b. model o3 – aż 78,6%, choć za cenę aż 7850 dolarów na przypadek.

Swoją drogą, teraz jak o tym myślę, to przypomina mi się mój inny post, który przedstawia nieprzyjemną (żeby delikatnie to ująć) prawdę o tym, jak ludzki osąd może się mylić. W tamtym artykule chodziło o orzeczenia wydawane przez sędziów zawodowych. Link (lub kliknij obrazek)

MAI-DxO, czyli orkiestrator lepszy niż lekarze

Przełomem okazał się jednak MAI Diagnostic Orchestrator (MAI-DxO) – specjalnie zaprojektowany system, który nie tyle „jest” AI, co „organizuje” AI. MAI-DxO symuluje naradę lekarską, w której uczestniczy pięciu wirtualnych „specjalistów” (np. Dr Hypothesis, Dr Test-Chooser, Dr Stewardship). Każdy ma własną rolę, a razem podejmują kolejne decyzje diagnostyczne. To tak, jakbyś w 5 różnych wątkach rozmowy z Gemini czy ChatGPT napisał 5 różnych promptów. Każdy prompt nadaje AI inną rolę i przekazuje mu inny kontekst, inne reguły działania i odpowiadania.

Efekty?

Gdy system ten korzystał z modelu o3, osiągnął 85,5% trafności i jednocześnie potrafił zredukować koszty o 70% względem niekontrolowanej AI. Co więcej – działał równie skutecznie na modelach od OpenAI, Google (Gemini), Anthropic (Claude) czy Meta (Llama). To solidny przykład tego, jak przemyślane orkiestracje mogą zmienić sposób działania dużych modeli językowych.

Wnioski dla HR i rekrutacji?

Na pierwszy rzut oka to badanie może wydawać się zarezerwowane wyłącznie dla świata medycyny. W mojej ocenie jego znaczenie sięga jednak znacznie dalej. Mamy tu do czynienia z przykładem modelowania decyzji sekwencyjnych – czyli takiego rodzaju rozumowania, które nie jest zarezerwowane dla lekarzy. Z takimi procesami mierzymy się przecież także w HR.

Przecież proces selekcji kandydatów, podobnie jak diagnoza medyczna, polega na stopniowym zbieraniu informacji – począwszy od CV, przez testy kompetencji, aż po rozmowy kwalifikacyjne. Systemy ATS pozwalają na częściową automatyzację tego procesu. Ale dopiero integracja z narzędziami AI, zaprojektowanymi z podobną logiką jak MAI-DxO, może stworzyć system, który nie tylko gromadzi dane, ale aktywnie podejmuje decyzje o kolejnych krokach, w sposób uporządkowany, świadomy i kosztowo efektywny.

Brzmi obiecująco, ale na razie to wciąż wizja przyszłości. Dlaczego?

Z kilku powodów.

Po pierwsze RODO i temat profilowania. Mówiąc w skrócie – chodzi o konieczność uzyskania wyraźnej zgody kandydata na to, by decyzje były podejmowane w sposób zautomatyzowany. A w praktyce? Większość firm takich zgód po prostu nie zbiera.

Po drugie halucynacje, czyli błędy generowane przez AI. To jedno z największych wyzwań. Co innego, gdy AI działa pod ścisłą kontrolą zespołu naukowców i lekarzy. Co innego, gdy z Gemini czy ChatGPT korzysta rekruter bez przeszkolenia, w pośpiechu, w realiach niedoboru kandydatów i nadmiaru zadań.

I tu dochodzimy do kolejnej różnicy – dostępu do zawodu. Żeby zostać lekarzem, potrzeba lat nauki, egzaminów, praktyk i odpowiedzialności prawnej. Żeby zostać rekruterem – nie potrzeba niczego takiego. Żadnych szkoleń, żadnych uprawnień, żadnych formalnych wymogów. Sądzę, że mimo wszelkich zastrzeżeń do poziomu leczenia, przeciętny lekarz podejdzie do AI z większą świadomością ryzyk i większym poczuciem odpowiedzialności niż przeciętny rekruter. To nie złośliwość w kierunku rekruterów, to uczciwe przedstawienie mojego postrzegania rzeczywistości.

Niech technologia wspiera nas wszystkich w podejmowaniu jak najlepszych decyzji, dla dobra nas wszystkich.

Najczęściej czytane:

- Darmowe ogłoszenia o pracę i największa lista źródeł kandydatów – największa w Polsce lista bezpłatnych i płatnych źródeł kandydatów

- Praca w HR – najnowsze oferty pracy i aktualne średnie wynagrodzenia w branży HR

- Akademia Rekrutacji – zbiór wiedzy na temat rekrutacji oraz raporty z rynku pracy.

- Gowork – jak reagować na negatywne opinie o pracodawcach – Kompleksowy poradnik dla pracodawców.

- Jak napisać CV i profil LinkedIn – kompleksowy poradnik tworzenia CV i profilów LinkedIn

- RODO w rekrutacji – sourcing, direct search, ogłoszenia. Wszystko co musisz wiedzieć – kompleksowy poradnik RODO w rekrutacji z naciskiem na działania typu direct search / sourcing.

- Wszystko o systemach ATS – poradnik wyboru systemu rekrutacyjnego

- Umowy przedwstępne i listy intencyjne w procesach rekrutacyjnych – wszystko, co musisz wiedzieć o prawnych zabezpieczeniach zobowiązania do zatrudnienia.

Maciej Michalewski

Founder & CEO @ Element

Ostatnie wpisy:

Rynek usług HR 2025 – co mówią dane z raportu PFHR

Polskie Forum HR opublikowało coroczny raport o kondycji rynku usług HR w Polsce. Element jest partnerem technologicznym PFHR, więc z podwójnym zainteresowaniem przyglądamy się tym

Nie widzę przyszłości dla MS Office

Trzy fazy przejścia od klikania w przyciski do poleceń AI. Dlaczego Microsoft Office jest skazany na wyginięcie i co go zastąpi.

Oferty rosną o 11%, a Dorsey tnie połowę firmy. Co się dzieje?

Oferty rosną o 11%, a Dorsey tnie połowę firmy. Co się dzieje? Wprowadzenie Dane, które mnie zaskoczyły Piszę o automatyzacji od lat. Uważam ją za

Nowość w Elemencie: integracja ze Staffly i automatyczne testy

Integracja Element ze Staffly automatyzuje wysylke testow kandydatom, pokazuje status wykonania i przyspiesza preselekcje z raportami w jednym miejscu.

AI intensyfikuje zamiast redukować pracę? Konsekwencje dla HR

Badania HBR pokazują, że AI intensyfikuje pracę zamiast ją redukować. Omówienie raportu opracowanego przez Harvard Business Review.

Raport ofert pracy – styczeń wyhamowuje spadki

Styczniowy raport ofert pracy rodzi mieszane uczucia. Trend jest wciąż spadkowy, ale spadek ten wyhamowuje. Przedstawiamy dane i komentarze.